BERT模型

简介

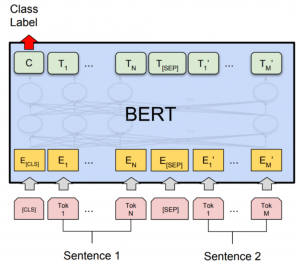

BERT模型采用了双向编码器的结构,这使得模型能够同时利用上下文信息进行预测,进一步提高了模型的性能。此外,BERT模型还引入了Masked Language Model(MLM)和Next Sentence Prediction(NSP)两个预训练任务,用于有效地利用大规模未标注的文本数据进行预训练。MLM任务要求模型恢复被随机遮盖的输入文本中的部分单词,以便学习单词之间的关系;NSP任务则要求模型判断两个句子是否是连续的,以便学习句子之间的关系。

BERT模型的优点在于其可以通过微调来适应各种自然语言处理任务,包括文本分类、命名实体识别、问答系统等。此外,BERT模型还可以与图像、视觉等其他模态相结合,实现跨模态的应用。

BERT模型在自然语言处理领域产生了巨大的影响,成为了自然语言处理领域的重要里程碑。其出现及其性能的提升,推动了自然语言处理技术的发展,产生了广泛的应用。

技术实现

BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer架构的神经网络模型,由Google公司开发。它是一种预训练的语言表示模型,可以用于NLP(Natural Language Processing)任务,如文本分类、命名实体识别和问答等。

BERT的主要技术实现如下:

1、Transformer架构:BERT采用了自注意力机制和多头注意力机制等技术,建立了Transformer架构。自注意力机制可以帮助模型自动地捕捉文本序列中的关系,多头注意力机制则可以增加模型的表示能力。

2、预训练:BERT在大规模的未标记文本上进行预训练,通过两个任务来进行预训练,即Masked Language Model(MLM)和Next Sentence Prediction(NSP)。其中,MLM任务是在输入文本中随机mask掉一部分单词,并让模型预测这些被mask的单词;NSP任务则是判断两个输入句子是否连续出现。

3、Fine-tuning:在完成预训练之后,BERT可以用于各种NLP任务。对于特定的任务,只需添加一个输出层,然后在特定数据集上微调模型即可。

4、序列长度限制:为了避免模型过于复杂和计算量过大,BERT对输入的序列长度进行了限制。通常情况下,BERT最长只能接受512个单词的序列。

总体而言,BERT模型的技术实现依赖于Transformer架构,预训练和fine-tuning两个关键步骤,并通过输入序列长度的限制来保证模型的运行效率。

应用领域

BERT模型在自然语言处理领域有着广泛的应用,主要应用领域包括但不限于:

1、语言表示学习:BERT模型能够学习一个句子的表示向量,从而在各种自然语言处理任务中提高性能。

2、文本分类:BERT模型可以用于对文本进行分类,如对电影评论进行情感分析等。

3、问答系统:BERT模型可以通过将问题和答案转化为文本,从而为问答系统提供更加准确的答案。

4、命名实体识别:BERT模型可以用于识别文本中的命名实体,如人名、地名、组织名等。

5、机器翻译:BERT模型可以用于机器翻译任务,提高翻译质量和速度。

6、句子相似度计算:BERT模型可以用于计算两个句子之间的相似度,对于信息检索和推荐系统有着重要的作用。

总之,BERT模型的应用领域非常广泛,其强大的表达能力和泛化性能,在自然语言处理领域的各种任务中都取得了非常好的表现。

技术挑战与展望

虽然BERT模型在自然语言处理领域取得了重大突破,但其仍面临着一些技术挑战。其中一些挑战包括:

1、训练和预测时间:由于BERT模型参数庞大,训练和预测时间都非常长。这限制了BERT模型在某些实时应用场景中的使用。

2、预训练数据量:BERT模型需要大量的未标注的文本数据进行预训练,这限制了模型的可扩展性和泛化能力。

3、多语种支持:当前的BERT模型主要针对英语,而对于其他语种的支持还比较有限。

4、句子长度限制:BERT模型对输入句子的长度有一定的限制。对于超过一定长度的句子,需要对其进行分割或截断,这可能会导致信息丢失或误判。

未来,为了解决上述问题,BERT模型的发展可以从以下几个方向展望:

1、模型轻量化:优化算法和模型架构,减小BERT模型的参数和计算量,使其更适用于实时应用场景。

2、数据增强:利用大规模的文本数据,采用更高效的训练方法,以增加BERT模型的泛化能力。

3、多语种支持:进一步发展和完善针对其他语种的BERT模型,扩大其应用领域。

4、跨模态结合:将BERT模型与其他模型、算法相结合,实现跨模态的应用,扩展BERT模型的应用场景。

总之,BERT模型的未来发展仍然面临着挑战,但随着技术的不断进步,相信BERT模型一定会在更广泛的领域中得到应用,并创造出更加优秀的表现。